เมื่อ AI เริ่ม “เข้าใจภาพ” ด้วยโครงสร้าง ไม่ใช่กำลัง brute force

Cr.Convolutional Neural Network (CNN): A Complete Guide

หลังปี 1986

Backpropagation ทำให้ Neural Networks

กลับมามีชีวิตอีกครั้ง

แต่มีปัญหาใหญ่อย่างหนึ่งที่ยังแก้ไม่ได้:

Neural Networks ไม่เก่งกับ “รูปภาพ”

และนี่ไม่ใช่ปัญหาเล็ก ๆ

เพราะรูปภาพคือข้อมูลจริงของโลก

ปัญหา: ทำไม Neural Networks แบบเดิมถึงพังกับรูปภาพ

เมื่อใช้ fully-connected neural networks กับ images

สิ่งที่เกิดขึ้นคือ:

- จำนวน parameters มหาศาล

- การฝึก ช้า และ ไม่เสถียร

- ต้องการข้อมูลและพลังประมวลผลมากเกินไป

- และที่แย่ที่สุด: ไม่เรียนรู้สิ่งที่ควรเรียนรู้

ภาพขนาดเล็กแค่ 32×32 pixels

ก็มี input มากกว่า 1,000 ตัวแล้ว

ถ้าเชื่อมต่อทุก pixel กับทุก neuron

network จะจมอยู่กับความซับซ้อนทันที

Insight ของ Yann LeCun: ปัญหาไม่ใช่การเรียนรู้ แต่คือโครงสร้าง

ที่ Bell Labs

Yann LeCun

ตั้งคำถามที่ต่างออกไปว่า:

แทนที่จะให้ network “generic”

ทำไมเราไม่ออกแบบ architecture

ที่รู้บางอย่างเกี่ยวกับ “ภาพ” ตั้งแต่ต้น?

นี่คือจุดคิดที่สำคัญมาก

LeCun ยอมรับความจริงพื้นฐานว่า:

Images มีโครงสร้างเชิงพื้นที่ (spatial structure)

pixel ที่อยู่ใกล้กัน

มักจะมีความหมายร่วมกัน

Neural Network ไม่ควรถูกบังคับให้

“ค้นพบความจริงข้อนี้เองตั้งแต่ศูนย์”

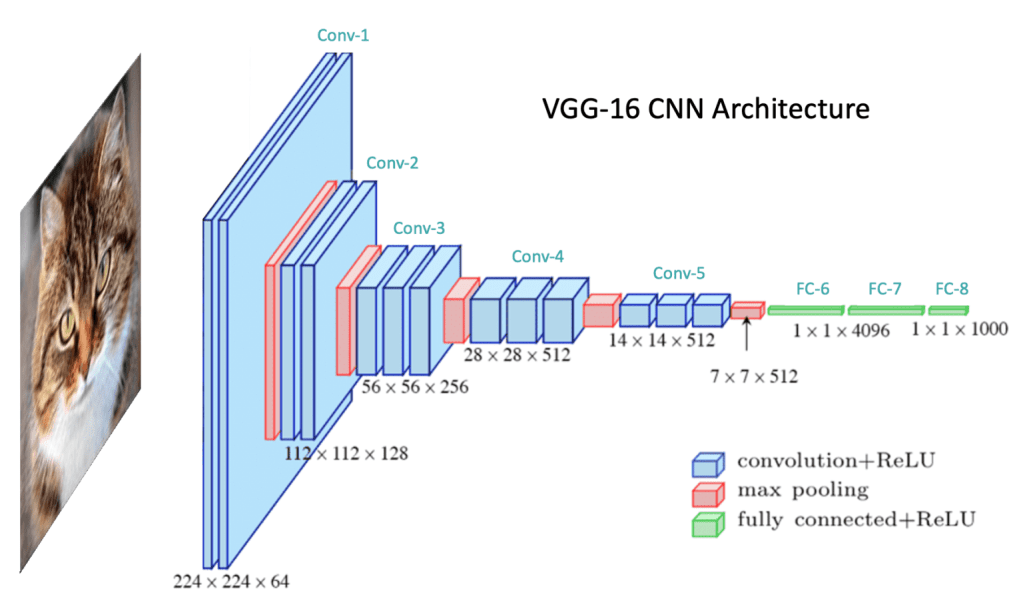

CNN คืออะไร?

Convolutional Neural Networks (CNNs)

ไม่ใช่แค่ neural network ที่ใหญ่ขึ้น

แต่มันคือ neural network

ที่ถูกออกแบบมา ให้สอดคล้องกับธรรมชาติของภาพ

แนวคิดหลักมี 3 อย่าง

1) Convolutional Layers: มองภาพทีละส่วน

แทนที่จะดูภาพทั้งภาพพร้อมกัน

CNN ใช้ filters ขนาดเล็ก

เลื่อนไปบนภาพ

- มองหา local features

เช่น ขอบ เส้น มุม - ไม่พยายามเข้าใจทุกอย่างพร้อมกัน

เหมือนมนุษย์

ที่ไม่มองภาพทั้งภาพด้วย pixel

แต่มอง “รูปแบบ”

2) Weight Sharing: เรียนรู้ครั้งเดียว ใช้ได้ทั้งภาพ

Filter หนึ่งตัว

สามารถใช้ตรวจจับ feature เดียวกัน

ได้ทุกตำแหน่งในภาพ

นี่เรียกว่า weight sharing

ผลลัพธ์คือ:

- ลดจำนวน parameters อย่างมหาศาล

- ไม่ต้องเรียนรู้ “ขอบแบบเดียวกัน” ซ้ำไปซ้ำมา

- ทำให้ network generalize ได้ดีขึ้น

3) Hierarchical Features: จากเส้น → รูปร่าง → วัตถุ

CNN เรียนรู้แบบเป็นลำดับชั้น:

- Layer แรก: ขอบ เส้น

- Layer ถัดไป: รูปร่างง่าย ๆ

- Layer ลึกขึ้น: วัตถุที่ซับซ้อน

นี่คือการเรียนรู้เชิงลำดับ

ที่สะท้อนวิธีการทำงานของระบบการมองเห็นในชีววิทยา

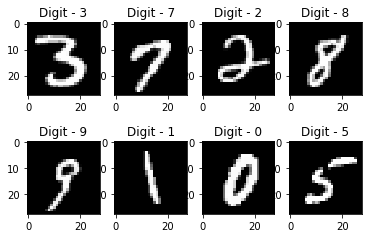

LeNet-5: CNN ที่พิสูจน์ว่า “ใช้ได้จริง”

CNN ไม่ได้หยุดอยู่แค่ทฤษฎี

LeCun สร้าง LeNet-5

เพื่อแก้ปัญหาที่เป็นรูปธรรมมาก:

การอ่านตัวเลขที่เขียนด้วยมือ

บนจดหมายไปรษณีย์

ระบบนี้ถูกนำไปใช้จริง

ในการอ่าน ZIP code ของไปรษณีย์สหรัฐ

ผลลัพธ์คือ:

- Accuracy มากกว่า 99%

- ทำงานได้ในสภาพแวดล้อมจริง

- เร็วและเสถียรพอสำหรับ production

นี่คือจุดสำคัญ:

CNN ไม่ใช่แค่ “ทำได้ในแล็บ”

แต่มันทำงานได้ในโลกจริง

ทำไม CNN สำคัญต่อประวัติศาสตร์ AI

CNN แสดงให้เห็นบทเรียนที่สำคัญมากว่า:

- การเรียนรู้ที่ดี

ไม่ได้มาจาก algorithm อย่างเดียว - Architecture คืออคติที่จำเป็น (useful bias)

- การใส่ “ความรู้เกี่ยวกับโดเมน”

ลงในโครงสร้างของโมเดล

ช่วยให้การเรียนรู้เป็นไปได้จริง

CNN คือการประนีประนอมที่ชาญฉลาด:

ไม่ต้องให้มนุษย์เขียนกฎทั้งหมด

แต่ก็ไม่ปล่อยให้โมเดล

เริ่มจากศูนย์โดยไม่รู้บริบท

ในปี 1989

CNN ประสบความสำเร็จจริง

แต่โลกยังไม่พร้อม

- ข้อมูลยังไม่มากพอ

- คอมพิวเตอร์ยังไม่แรงพอ

- GPU ยังไม่ถูกใช้กับ AI

CNN ต้องรออีกเกือบ 20 ปี

ก่อนที่โลกจะเห็นพลังของมันเต็มรูปแบบ

ในยุค Deep Learning หลังปี 2012

แต่เมล็ดพันธุ์

ถูกหว่านไว้แล้ว

และชื่อของ

Yann LeCun

จะกลับมาอีกครั้ง

ในฐานะหนึ่งใน “บิดาแห่ง Deep Learning”

บทสรุป: การฟื้นคืนชีพที่เงียบ แต่ลึก

Backpropagation และ Convolutional Neural Networks

ไม่ได้ทำให้ AI “ฉลาด” ขึ้นในชั่วข้ามคืน

และมันไม่ได้แก้ปัญหาทั้งหมดของปัญญาประดิษฐ์

แต่สิ่งที่มันทำได้

สำคัญกว่านั้นมาก

มันทำให้การเรียนรู้ของเครื่อง

เป็นไปได้จริงในทางปฏิบัติ

ก่อนหน้านี้

AI ต้องพึ่งพาความรู้ที่มนุษย์อธิบายได้

ต้องเขียนกฎ

ต้องถ่ายทอดความเชี่ยวชาญทีละชิ้น

ถ้า Expert Systems

คือการส่งผ่านความรู้จาก

มนุษย์ → เครื่อง

Backpropagation

คือการเปลี่ยนบทบาททั้งหมด

มันไม่ถามว่า

“มนุษย์รู้กฎอะไร”

แต่มันปล่อยให้เครื่อง

เรียนรู้จากความผิดพลาดของตัวเอง

ลองผิด

วัดผล

ย้อนกลับ

ปรับตัว

แล้วลองใหม่

ไม่ต้องเข้าใจโลกเหมือนมนุษย์

แค่เรียนรู้ให้ดีพอจากข้อมูลก็พอ

และจากจุดเปลี่ยนเล็ก ๆ ตรงนี้เอง

เส้นทางใหม่ของ AI ก็เปิดออก

- Machine Learning

- Deep Learning

- และ AI ในโลกปัจจุบัน

การฟื้นคืนชีพครั้งนี้

ไม่ได้มาพร้อมเสียงดัง

หรือคำสัญญาใหญ่โต

แต่มันเปลี่ยน “วิธีที่ AI เรียนรู้” ไปตลอดกาล

อ่านต่อที่ ( บทความต่อไปกำลังเขียนอยู่ครับ…)