ความเข้าใจผิดแรก: “ถ้าเรารู้กฎ เราก็รู้ทุกอย่าง”

Cr.Expert systems and Machine learning..Kunal Verma

ในช่วงทศวรรษ 1960s–1970s

นักวิจัย AI เชื่อว่าพวกเขา “มาถูกทางแล้ว”

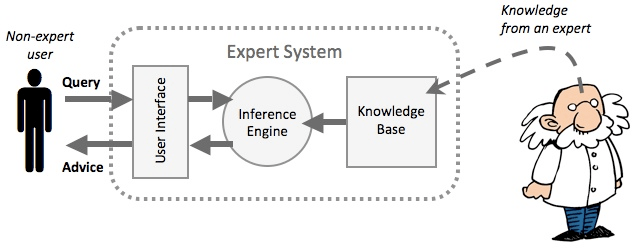

พวกเขาเริ่มสร้างสิ่งที่เรียกว่า Expert Systems

ระบบ AI ที่พยายามดึง expertise ของมนุษย์

มาแปลงเป็นกฎตรรกศาสตร์

ตัวอย่างที่มีชื่อเสียง ได้แก่

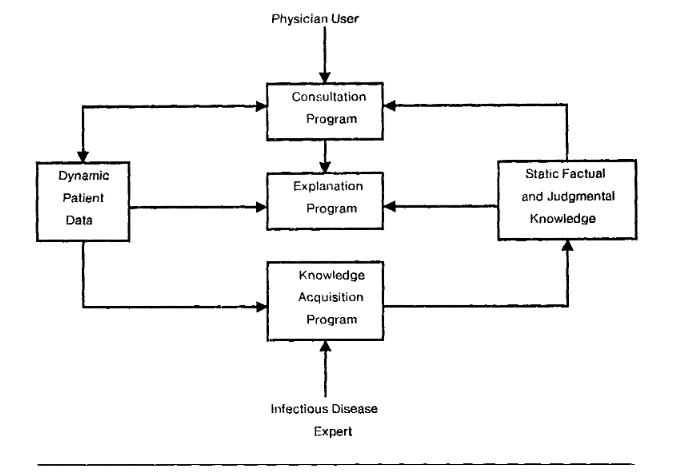

- MYCIN — ระบบวินิจฉัยโรคติดเชื้อ

- DENDRAL — ระบบวิเคราะห์โครงสร้างโมเลกุล

- XCON — ระบบกำหนดค่า hardware ของ

Digital Equipment Corporation

ในโลกของปัญหาที่แคบและควบคุมได้

ระบบเหล่านี้ ทำงานได้ดีจริง

XCON ถึงขั้นช่วยประหยัดต้นทุนให้ DEC

มากกว่า 40 ล้านดอลลาร์ต่อปี

ในสายตาคนยุคนั้น

AI ดูเหมือนจะ “สำเร็จแล้ว”

แต่ปัญหาที่แท้จริง

ถูกซ่อนอยู่ใต้ความสำเร็จเหล่านี้

Knowledge Acquisition Bottleneck: คอขวดที่ไม่มีใครอยากมอง

Expert systems ทุกระบบ

มีเงื่อนไขร่วมกันอย่างหนึ่ง:

ทุกความรู้ ต้องถูกเข้ารหัสด้วยมือ

Cr.What is Symbolic artificial intelligence?

ถ้าคุณต้องการให้ระบบวินิจฉัยโรค

คุณต้อง:

- สัมภาษณ์แพทย์ผู้เชี่ยวชาญ

- แปลงความรู้ของเขาเป็นกฎ เช่น

“ถ้าอุณหภูมิ > 38.5°C และเจ็บคอ → เป็น strep throat” - ทำซ้ำขั้นตอนนี้

ไม่ใช่สิบครั้ง

แต่เป็น หลายพันครั้ง

นี่คือสิ่งที่เรียกว่า

Knowledge Acquisition Bottleneck

— การรวบรวมความรู้คือคอขวด

เมื่อ XCON ขยายตัว

จำนวนกฎเพิ่มจากประมาณ 750 ข้อ

เป็นมากกว่า 17,000 ข้อ

ทีม knowledge engineers

ต้องนั่งเขียน แก้ และ debug กฎเหล่านี้ไม่รู้จบ

และนี่เป็นเพียง

ปัญหาแรก

จุดเริ่มต้น: AI ที่ไม่ได้ตั้งใจจะเกิด

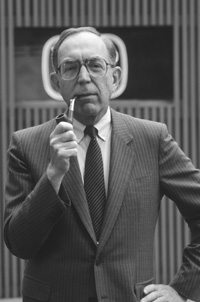

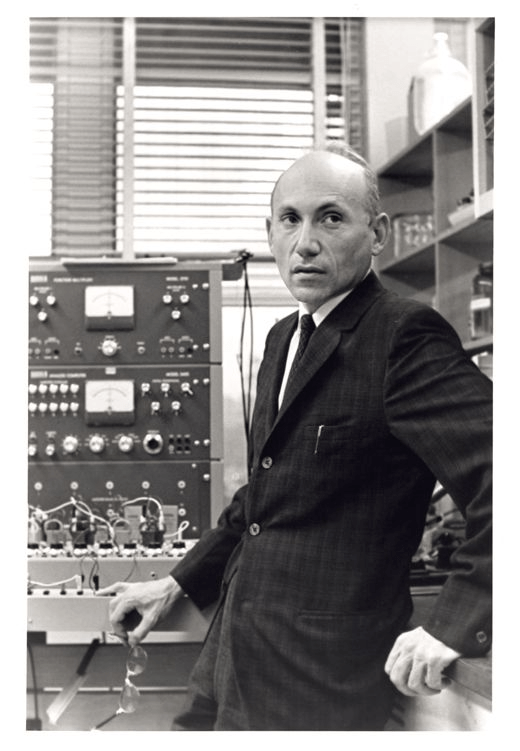

ในช่วงต้นทศวรรษ 1960

Edward Feigenbaum

นักวิทยาศาสตร์คอมพิวเตอร์จาก Stanford

ไม่ได้ตั้งใจจะสร้าง “ระบบผู้เชี่ยวชาญ”

สิ่งที่เขาสนใจจริง ๆ คือคำถามคลาสสิกของ AI ยุคแรก:

เราจะจำลอง “กระบวนการคิด” ของมนุษย์

โดยเฉพาะนักวิทยาศาสตร์

ได้หรือไม่?

Feigenbaum อยากเข้าใจว่า

นักวิทยาศาสตร์สร้าง สมมติฐาน จากข้อมูลที่ไม่สมบูรณ์ได้อย่างไร

พวกเขา “เดาอย่างมีเหตุผล” ได้อย่างไร

คำตอบนี้

เขาไม่ได้ค้นพบในห้องแล็บคอมพิวเตอร์

การพบกันที่เปลี่ยนทิศทาง AI

ในปี 1964

Feigenbaum ได้พบกับ

Joshua Lederberg

Lederberg อธิบายว่า

นักเคมีอินทรีย์สามารถคาดเดาโครงสร้างโมเลกุล

จากข้อมูลของเครื่อง mass spectrometer ได้อย่างไร

พวกเขาไม่ได้คำนวณทุกความเป็นไปได้

แต่ใช้ “ประสบการณ์”

ใช้กฎลัด

ใช้การเดาแบบมีหลักการ

และในบทสนทนานั้นเอง

Lederberg กล่าวประโยคที่กลายเป็นจุดเปลี่ยนของ AI ว่า:

“We were not inventing artificial intelligence.

We were inventing expert systems.”

พวกเขาคิดว่ากำลังสร้าง “สมองเทียม”

แต่สิ่งที่เกิดขึ้นจริงคือ

ระบบที่จำลองความเชี่ยวชาญเฉพาะทาง

และจากจุดนี้

แนวคิดสำคัญที่สุดของ AI ยุคนั้นก็ถือกำเนิดขึ้น:

Knowledge is Power

ความรู้คืออำนาจ

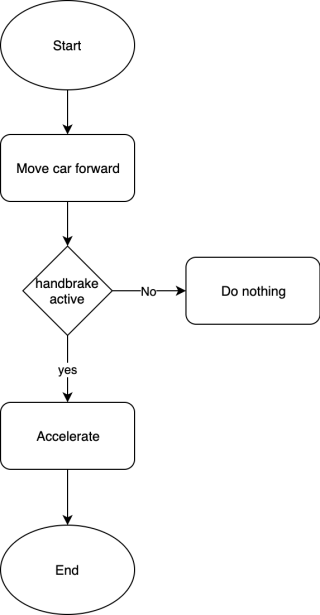

Brittleness: ความเปราะบางที่โลกจริงไม่ให้อภัย

ปัญหาที่ร้ายแรงยิ่งกว่า Expert System คือ

brittleness — ความเปราะบาง

Expert systems ทำงานได้ดี

เฉพาะในโลกที่ถูกเตรียมมาอย่างสมบูรณ์

- ข้อมูลครบ

- ไม่มีข้อยกเว้น

- ไม่มีความคลุมเครือ

แต่โลกจริง

ไม่ทำงานแบบนั้น

ตัวอย่างง่าย ๆ:

ถ้าระบบวินิจฉัยโรค

ถูกเขียนกฎมา 1,000 ข้อ

แล้วคนไข้บอกว่า

“เป็นไข้ แต่ยังไม่ได้วัดอุณหภูมิ”

ระบบจะ “ติด” ทันที

เพราะกฎไม่ครบ

มนุษย์สามารถอนุมาน

ถามต่อ

ใช้ประสบการณ์

แต่เครื่องจักรทำไม่ได้…

Combinatorial Explosion: ปัญหาที่ฆ่า AI อย่างเงียบ ๆ

ปัญหานี้ถูกชี้อย่างเป็นทางการ

โดย James Lighthill

ในปี 1973

เขาได้รับมอบหมายจากรัฐสภาอังกฤษ

ให้ประเมินงานวิจัย AI

ผลลัพธ์คือรายงานชื่อ

“Artificial Intelligence: A General Survey”

หรือที่รู้จักกันในชื่อ Lighthill Report

ใจความสำคัญของรายงานคือปัญหา

Combinatorial Explosion

อธิบายง่าย ๆ:

ในเกมหมากรุก

- หนึ่งตา มีทางเลือก ~20 ทาง

- มองล่วงหน้า 5 ตา

- จำนวนความเป็นไปได้ = 20⁵ = 3.2 ล้านทาง

สำหรับคอมพิวเตอร์ยุค 1970s

นี่พอจัดการได้

แต่โลกจริง

ไม่ใช่หมากรุก

มันมีตัวแปรนับล้าน

ความไม่แน่นอน

และข้อยกเว้นที่ไม่รู้จบ

ข้อสรุปของ Lighthill คือ:

AI ทำงานได้

เพราะปัญหาที่มันแก้

เป็นเพียง “toy problems”

ไม่ใช่ปัญหาของโลกจริง

ความล้มเหลวคู่ขนาน: Perceptron และ Neural Network ยุคแรก

ในขณะเดียวกัน

อีกแนวทางหนึ่งก็ล้มเหลวไปพร้อมกัน

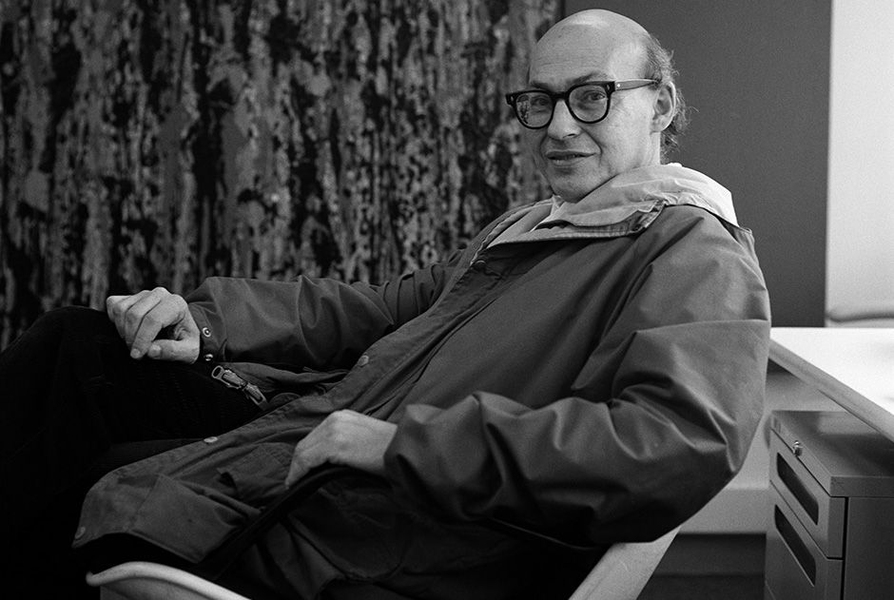

นักวิจัยอย่าง

Warren McCulloch, Donald Hebb และ

Frank Rosenblatt

พยายามสร้าง AI โดยเลียนแบบสมอง

Rosenblatt พัฒนา Perceptron

ซึ่งดูเหมือนจะ “เรียนรู้ได้”

แต่ในปี 1969

Marvin Minsky และ

Seymour Papert

ตีพิมพ์หนังสือ Perceptrons

พวกเขาพิสูจน์ว่า

perceptron ชั้นเดียว

ไม่สามารถแก้ปัญหาไม่เชิงเส้นได้

ตัวอย่างคลาสสิกคือ XOR problem

ผลกระทบมหาศาล:

- Funding ด้าน neural networks หาย

- งานวิจัยถูกมองว่า “ตันทางทฤษฎี”

- เงินทั้งหมดไหลไปที่ Symbolic AI

สรุปคือ:

- Symbolic AI ล้มเหลวเพราะ brittleness + combinatorial explosion

- Neural networks ถูกทิ้งเพราะข้อจำกัดทางทฤษฎี (ในเวลานั้น)

AI ล้มเหลว

จาก สองทิศทางพร้อมกัน

ผลลัพธ์: AI Winter ครั้งแรก (1974–1980)

Lighthill Reportและหนังสือ Perceptrons

ไม่ได้เป็นแค่บทวิจารณ์ทางวิชาการ

แต่มัน ฆ่าความเชื่อมั่นของทั้งระบบ

ผลลัพธ์คือ:

- รัฐบาลอังกฤษตัด funding AI ลงกว่า 90%

- ห้องแล็บ AI ปิด

- มหาวิทยาลัยหยุดรับนักวิจัยด้าน AI

- นักวิจัยดาวรุ่งหางานไม่ได้

- สหรัฐอเมริกาก็ตามรอยเดียวกัน

เหตุผลของผู้บริหารในยุคนั้นเรียบง่ายมาก:

“AI ไม่ได้ส่งมอบสิ่งที่สัญญาไว้”

พวกเขาได้รับ

ระบบ expert แคบ ๆ

ที่ต้องการ maintenance สูง

ปรับขยายไม่ได้

และพังทันทีเมื่อโลกเปลี่ยน

ประโยคของ John McCarthy

ใน Lighthill debate ปี 1973

สะท้อนความจริงได้อย่างเจ็บปวด:

“ถ้าผู้บุกเบิก AI บอกความจริง

ว่าพวกเขารู้อะไร และไม่รู้อะไร

การสนับสนุนอาจไม่พังทลายเช่นนี้”

แก่นแท้ของปัญหาคือ

สัญญามากเกินไป

และยอมรับความไม่รู้ น้อยเกินไป

อ่านต่อ https://genaispace.net/ai-winter-ครั้งแรก-1980-1990s/