Geoffrey Hinton, Backpropagation และจุดหักเหปี 1986

ปัญหาเก่า: ทำไม Neural Networks ถึงถูกทิ้งไป?

ก่อนจะเข้าใจว่าทำไม Neural Networks ถึง “ฟื้นคืนชีพ”

เราต้องย้อนกลับไปยังเหตุผลที่มัน เคยตายไปก่อน

ในปี 1969

Marvin Minsky

พิสูจน์ว่า single-layer perceptron

ไม่สามารถแก้ปัญหาง่ายแต่สำคัญอย่าง XOR problem ได้

ผลกระทบไม่ได้เล็กน้อยเลย

- เงินทุนวิจัย Neural Networks

ถูกตัดลงมากกว่า 90% - นักวิจัยเปลี่ยนสาย

- Neural Networks ถูกมองว่า

“สวยในเชิงชีววิทยา แต่ใช้ไม่ได้จริง”

เป็นเวลากว่า 15 ปี

Neural Networks ถูกทิ้งไว้ข้างทาง

แม้ในทางทฤษฎี

เราจะรู้ว่า multi-layer neural networks

สามารถแก้ XOR และปัญหาไม่เชิงเส้นได้

แต่มีปัญหาใหญ่เพียงข้อเดียว:

ไม่มีใครรู้ว่าจะฝึก (train) มันอย่างไร

ให้ได้ผลจริง

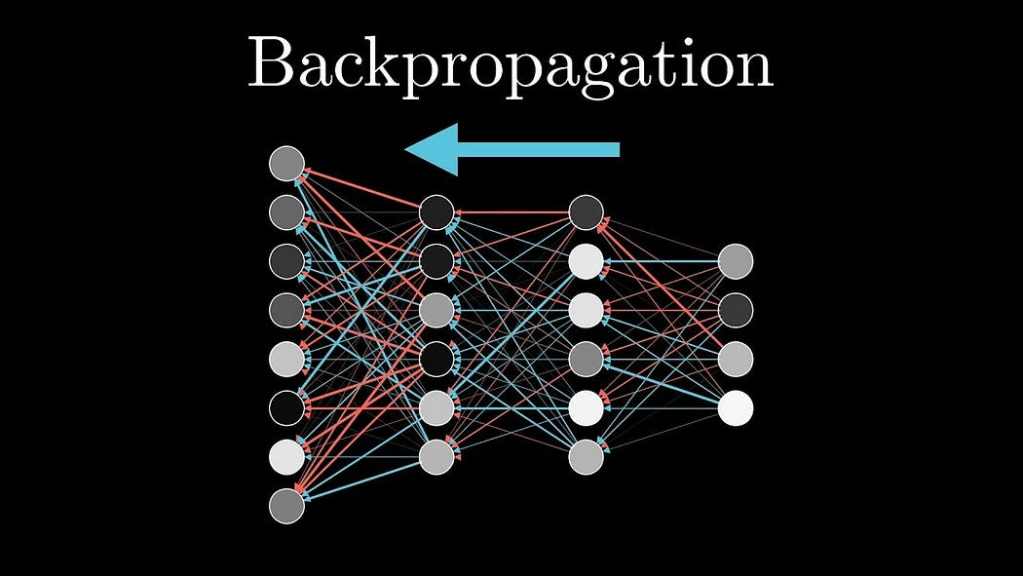

Backpropagation: การเรียนรู้จากความผิดพลาด

จุดเปลี่ยนเกิดขึ้นในปี 1986

Geoffrey Hinton,

David Rumelhart

และ Ronald Williams

ตีพิมพ์บทความชื่อ

“Learning representations by back-propagating errors”

บทความนี้

ไม่ได้เสนอโมเดลใหม่

แต่เสนอ วิธีเรียนรู้ใหม่

Backpropagation ทำงานอย่างไร (อธิบายแนวคิด ไม่ได้อธิบายในเชิงคณิตศาสตร์)

Backpropagation แปลตรงตัวคือ

“การส่งความผิดพลาดย้อนกลับ”

หลักการของมันเรียบง่ายมาก:

- ให้ neural network ทำนายผลลัพธ์

- วัดว่า มันผิดไปเท่าไร (error)

- ส่ง error นี้

ย้อนกลับผ่านแต่ละชั้นของ network - ปรับน้ำหนัก (weights)

ของแต่ละ connection

ตามระดับ “ความรับผิดชอบ” ต่อความผิดพลาดนั้น

หัวใจสำคัญคือสิ่งที่เรียกว่า

credit assignment problem

ส่วนไหนของ network

ควรถูก “ชม”

และส่วนไหน

ควรถูก “ตำหนิ”

Backpropagation แก้ปัญหานี้

ด้วย chain rule จากแคลคูลัส

ไม่ใช่ด้วยสัญชาตญาณ

ไม่ใช่ด้วยกฎมือ

แต่ด้วยคณิตศาสตร์ที่ชัดเจน

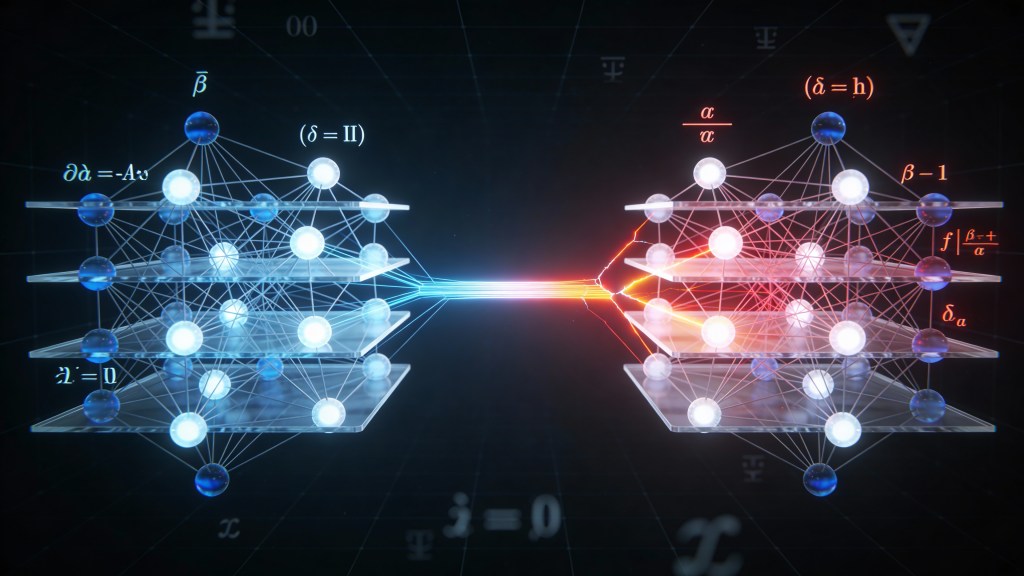

ทำไม Backpropagation ถึงเปลี่ยนทุกอย่าง

Backpropagation สำคัญ

ไม่ใช่เพราะมัน “ฉลาด”

แต่เพราะมัน ใช้งานได้จริง

สิ่งที่มันทำได้:

- ฝึก multi-layer networks ได้จริง

- แก้ปัญหา XOR และ non-linear problems

- เรียนรู้ pattern ที่ซับซ้อนได้

- เร็วกว่า algorithm รุ่นก่อนอย่างมาก

เป็นครั้งแรกที่ Neural Networks

ไม่ใช่แค่แนวคิดสวย ๆ

แต่เป็น เครื่องมือที่ฝึกได้

ผลลัพธ์: Neural Networks กลับมาอีกครั้ง

ก่อนหน้า Backpropagation:

- Symbolic AI

→ ต้องให้มนุษย์เขียนกฎด้วยมือ - Neural Networks

→ มีแนวคิด แต่ไม่มีวิธีฝึกที่ดี

หลังปี 1986:

- Neural Networks

→ มี training algorithm ที่ใช้งานได้ - โลกเริ่มมี ข้อมูลดิจิทัลจำนวนมากขึ้น

(ฐานข้อมูล, ไฟล์, อินเทอร์เน็ตยุคแรก)

ผลลัพธ์คือ:

นักวิจัยรุ่นใหม่

เริ่มกลับมาสนใจ Neural Networks

ไม่ใช่เพราะมัน “เหมือนสมอง”

แต่เพราะมัน เรียนรู้จากข้อมูลได้จริง

จุดเปลี่ยนเชิงปรัชญา: จาก Knowledge → Data

นี่คือจุดที่ AI

เปลี่ยนโลกทัศน์อย่างแท้จริง

- 1970s–1980s

→ “Knowledge is Power”

→ Symbolic AI, Expert Systems - 1980s–1990s เป็นต้นมา

→ “Data is Power”

→ Machine Learning, Neural Networks

AI ไม่ได้พยายาม

“เข้าใจโลกเหมือนมนุษย์”

แต่มันเริ่ม

จับรูปแบบจากข้อมูลจำนวนมาก

และ Backpropagation

คือสะพานสำคัญ

ที่พา AI ข้ามจากโลกเก่า

สู่โลกใหม่

อ่านต่อที่ https://genaispace.net/yann-lecun-และ-convolutional-neural-networks-1989/